文章目录[x]

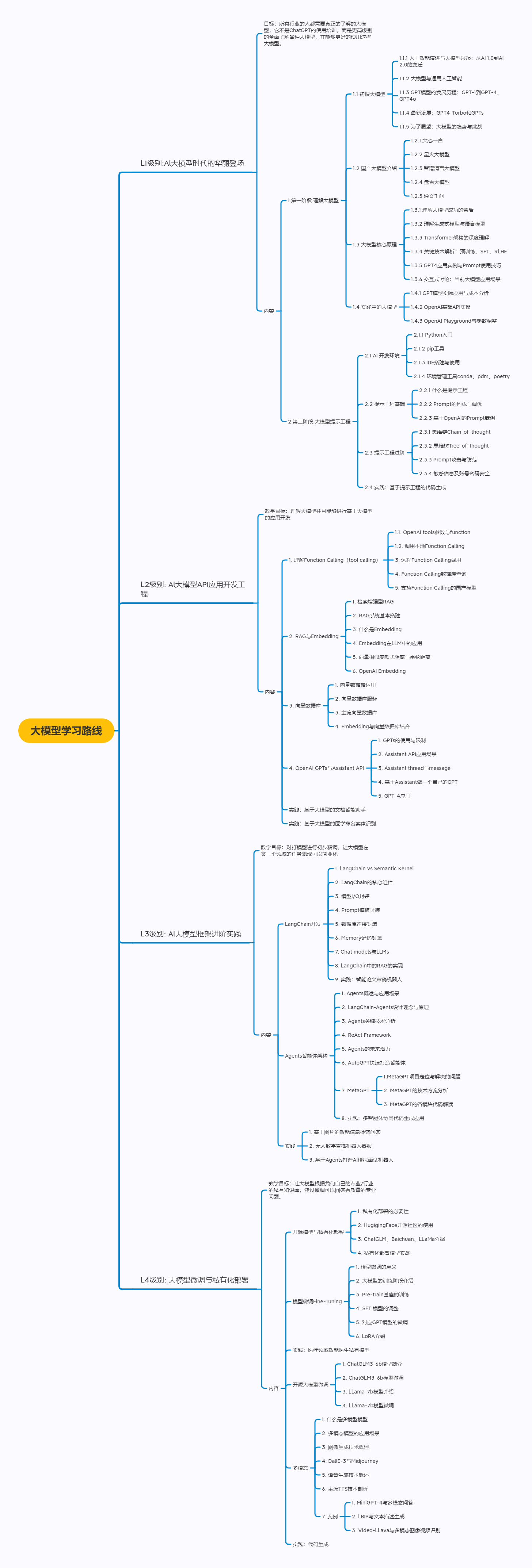

- 1:# 大模型学习路线

- 1.1:## L1级别:Al大模型时代的华丽登场

- 1.2:## L2级别: Al大模型API应用开发工程

- 1.3:## L3级别: Al大模型框架进阶实践

- 1.4:## L4级别: 大模型微调与私有化部署

# 大模型学习路线

## L1级别:Al大模型时代的华丽登场

### 目标:所有行业的人都需要真正的了解的大模型,它不是ChatGPT的使用培训,而是更高级别的全面了解各种大模型,并能够更好的使用这些大模型。

### 内容

- 1.第一阶段.理解大模型

- 1.1 初识大模型

- 1.1.1 人工智能演进与大模型兴起:从AI 1.0到AI 2.0的变迁

- 1.1.2 大模型与通用人工智能

- 1.1.3 GPT模型的发展历程:GPT-1到GPT-4

- 1.1.4 最新发展:GPT4-Turbo和GPTs

- 1.1.5 为了展望:大模型的趋势与挑战

- 1.2 国产大模型介绍

- 1.2.1 文心一言

- 1.2.2 星火大模型

- 1.2.3 智谱清言大模型

- 1.2.4 盘古大模型

- 1.2.5 通义千问

- 1.3 大模型核心原理

- 1.3.1 理解大模型成功的背后

- 1.3.2 理解生成式模型与语言模型

- 1.3.3 Transformer架构的深度理解

- 1.3.4 关键技术解析:预训练、SFT、RLHF

- 1.3.5 GPT4应用实例与Prompt使用技巧

- 1.3.6 交互式讨论:当前大模型应用场景

- 1.4 实践中的大模型

- 1.4.1 GPT模型实际应用与成本分析

- 1.4.2 OpenAI基础API实操

- 1.4.3 OpenAI Playground与参数调整

- 2.第二阶段.大模型提示工程

- 2.1 AI 开发环境

- 2.1.1 Python入门

- 2.1.2 pip工具

- 2.1.3 IDE搭建与使用

- 2.2 提示工程基础

- 2.2.1 什么是提示工程

- 2.2.2 Prompt的构成与调优

- 2.2.3 基于OpenAI的Prompt案例

- 2.3 提示工程进阶

- 2.3.1 思维链Chain-of-thought

- 2.3.2 思维树Tree-of-thought

- 2.3.3 Prompt攻击与防范

- 2.3.4 敏感信息及账号密码安全

- 2.4 实践:基于提示工程的代码生成

## L2级别: Al大模型API应用开发工程

### 目标:理解大模型并且能够进行基于大模型的应用开发

### 内容

- 1. 理解Function Calling(tool calling)

- 1.1. OpenAI tools参数与function

- 1.2. 调用本地Function Calling

- 3. 远程Function Calling调用

- 4. Function Calling数据库查询

- 5. 支持Function Calling的国产模型

- 2. RAG与Embedding

- 1. 检索增强型RAG

- 2. RAG系统基本搭建

- 3. 什么是Embedding

- 4. Embedding在LLM中的应用

- 5. 向量相似度欧式距离与余弦距离

- 6. OpenAI Embedding

- 3. 向量数据库

- 1. 向量数据据运用

- 2. 向量数据库服务

- 3. 主流向量数据库

- 4. Embedding与向量数据库结合

- 4. OpenAI GPTs与Assistant API

- 1. GPTs的使用与限制

- 2. Assistant API应用场景

- 3. Assistant thread与message

- 4. 基于Assistant做一个自己的GPT

- 5. GPT-4应用

- 实践:基于大模型的文档智能助手

- 实践:基于大模型的医学命名实体识别

## L3级别: Al大模型框架进阶实践

### 目标:对打模型进行初步精调,让大模型在某一个领域的任务表现可以商业化

### 内容

- LangChain开发

- 1. LangChain vs Semantic Kernel

- 2. LangChain的核心组件

- 3. 模型I/O封装

- 4. Prompt模板封装

- 5. 数据库连接封装

- 6. Memory记忆封装

- 7. Chat models与LLMs

- 8. LangChain中的RAG的实现

- 9. 实践:智能论文审稿机器人

- Agents智能体架构

- 1. Agents概述与应用场景

- 2. LangChain-Agents设计理念与原理

- 3. Agents关键技术分析

- 4. ReAct Framework

- 5. Agents的未来潜力

- 6. AutoGPT快速打造智能体

- 7. MetaGPT

- 1.MetaGPT项目定位与解决的问题

- 2. MetaGPT的技术方案分析

- 3. MetaGPT的各模块代码解读

- 8. 实践:多智能体协同代码生成应用

- 实践

- 1. 基于图片的智能信息检索问答

- 2. 无人数字直播机器人客服

- 3. 基于Agents打造AI模拟面试机器人

## L4级别: 大模型微调与私有化部署

### 目标:让大模型根据我们自己的专业/行业的私有知识库,经过微调可以回答有质量的专业问题。

### 内容

- 开源模型与私有化部署

- 1. 私有化部署的必要性

- 2. HugigingFace开源社区的使用

- 3. ChatGLM、Baichuan、LLaMa介绍

- 4. 私有化部署模型实战

- 模型微调Fine-Tuning

- 1. 模型微调的意义

- 2. 大模型的训练阶段介绍

- 3. Pre-train基座的训练

- 4. SFT 模型的调整

- 5. 对应GPT模型的微调

- 6. LoRA介绍

- 实践:医疗领域智能医生私有模型

- 开源大模型微调

- 1. ChatGLM3-6b模型简介

- 2. ChatGLM3-6b模型微调

- 3. LLama-7b模型介绍

- 4. LLama-7b模型微调

- 多模态

- 1. 什么是多模型模型

- 2. 多模态模型的应用场景

- 3. 图像生成技术概述

- 4. DallE-3与Midjourney

- 5. 语音生成技术概述

- 6. 主流TTS技术剖析

- 7. 案例

- 1. MiniGPT-4与多模态问答

- 2. LBIP与文本描述生成

- 3. Video-LLava与多模态图像视频识别

- 实践:代码生成

不错

b不错

得瑟得瑟