- 1:3.1 下载Ollama

- 2:3.2 安装Ollama

- 3:3.3 配置Ollama的模型路径和端口

- 4:3.4 下载qwen2.5-coder 7b模型

- 5:3.5 Ollama命令

- 6:3.6 API

- 7:4.1 安装docker

- 8:4.2 安装OpenWebUI

- 9:4.3 设置管理员账户

- 10:4.4 配置ollama

- 11:5.1使用docker安装searxng

- 12:5.2 修改searxng配置

- 13:5.3 Openwebui配置searxng

1. 效果演示

2. 软硬件配置

| 系统 | Windows10 |

| 内存 | 16G |

| 磁盘 | 50G |

| 显卡 | 1660TI(6G) |

| 软件 | Docker |

3. 安装Ollama

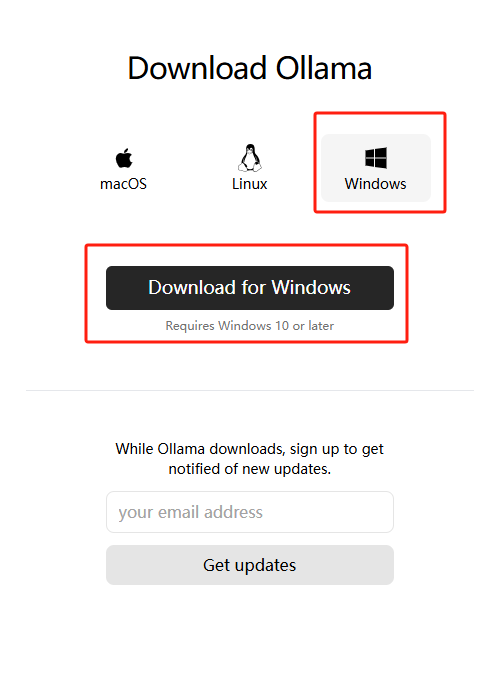

3.1 下载Ollama

Ollama官网下载Ollama安装包:https://ollama.com/

3.2 安装Ollama

Windows下安装Ollama很简单,双击运行安装文件即可,此处不赘述。

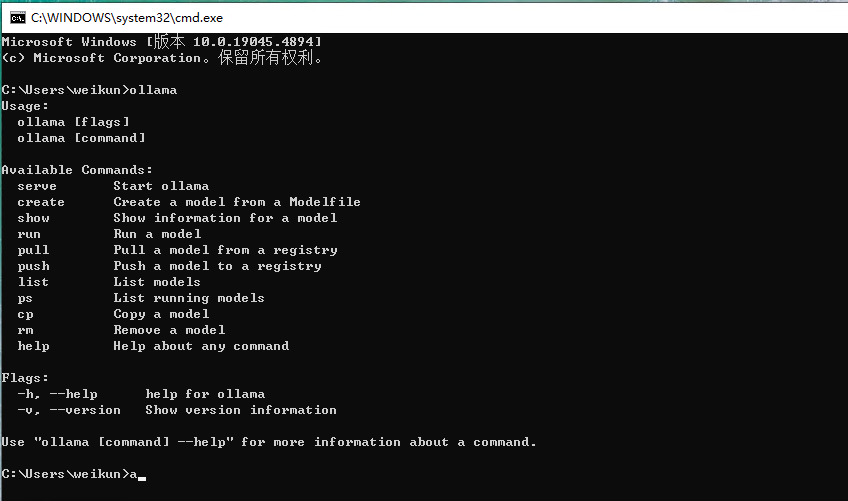

打开终端,输入ollama,出现下图所示代表安装成功

注意:

windows 的安装默认不支持修改程序安装目录,

默认安装后的目录:C:\Users\username\AppData\Local\Programs\Ollama

默认安装的模型目录:C:\Users\username\ .ollama

默认的配置文件目录:C:\Users\username\AppData\Local\Ollama

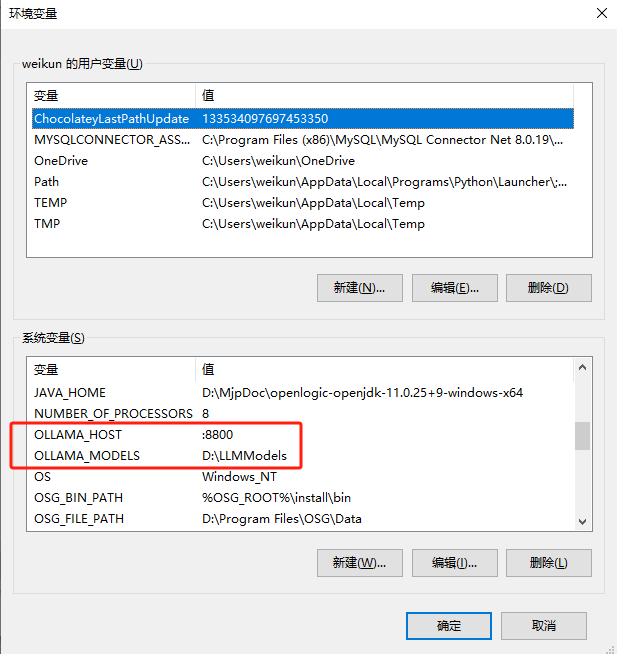

3.3 配置Ollama的模型路径和端口

由于Ollama的模型默认会在C盘用户文件夹下的.ollama/models文件夹中,可以配置环境变量OLLAMA_MODELS和OLLAMA_HOST,设置为指定的路径和端口:

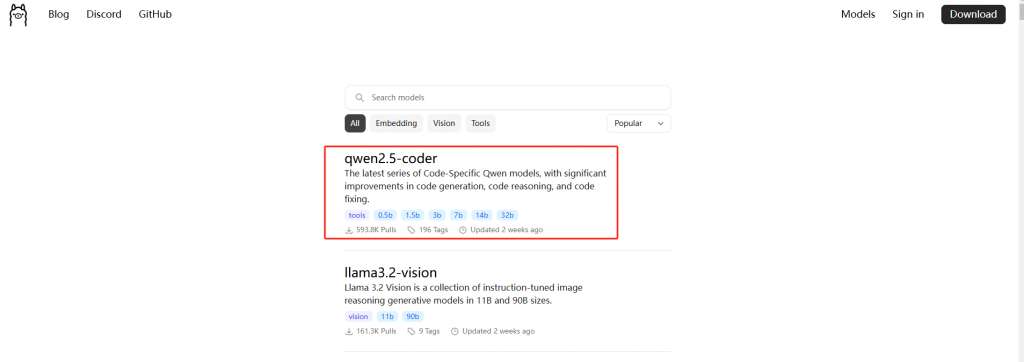

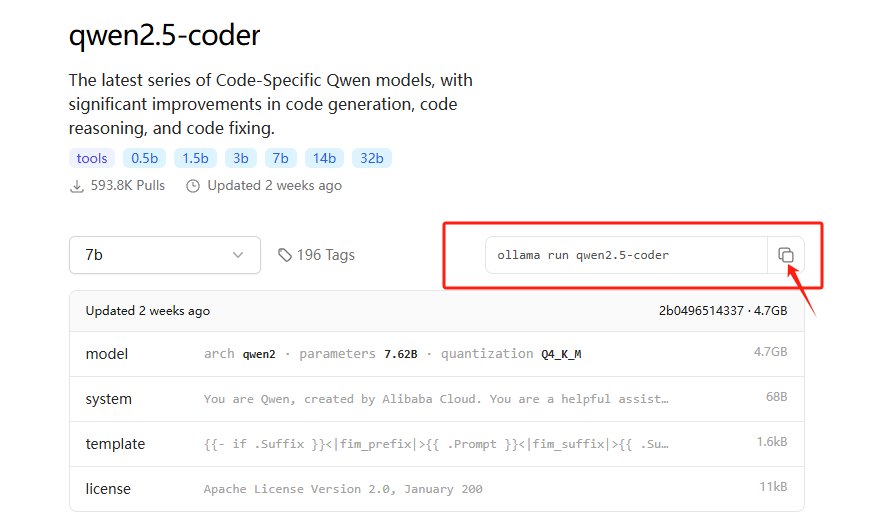

3.4 下载qwen2.5-coder 7b模型

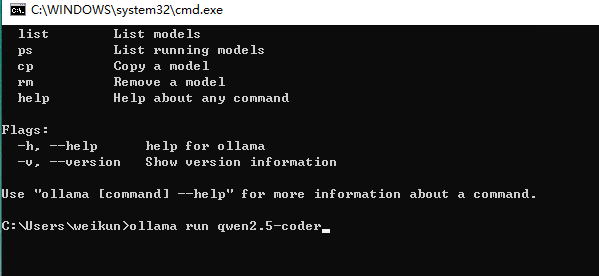

从ollama官网首页右上角点击“Models”进入ollama官方提供的模型列表,我们可以从中选用合适的模型进行下载安装。以qwen2.5-coder 7b为例。

- 点击5-coder进入详情页。

- 选择7b参数的模型。

- 复制命令。

- 在命令行中粘贴命令,并执行。

- 等待模型下载完成,就可以在命令行窗口中对话了。

- 输入/bye退出对话模式。

3.5 Ollama命令

| 启动Ollama服务 | ollama serve |

| 2. 从模型文件创建模型 | ollama create |

| 3. 显示模型信息 | ollama show |

| 4. 运行模型 | ollama run 模型名称 |

| 5. 从注册表中拉去模型 | ollama pull 模型名称 |

| 6. 将模型推送到注册表 | ollama push |

| 7. 列出模型 | ollama list |

| 8. 复制模型 | ollama cp |

| 9. 删除模型 | ollama rm 模型名称 |

| 10. 获取有关Ollama任何命令的帮助信息 | ollama help |

3.6 API

Ollama同时提供与openai一样的兼容web接口,可以在命令行以外的地方使用对话功能和部署模型功能。https://github.com/ollama/ollama/blob/main/docs/api.md

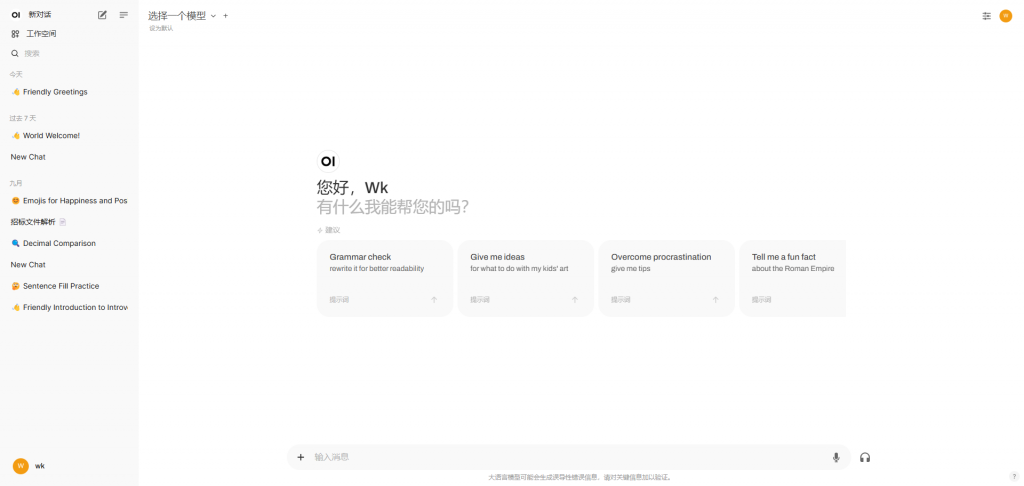

可以使用python代码去连接到本地的大模型,也可以使用一些开源的项目去连接,下面介绍OpenWebUI的使用。

4. 安装OpenWebUI

4.1 安装docker

略

4.2 安装OpenWebUI

Docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

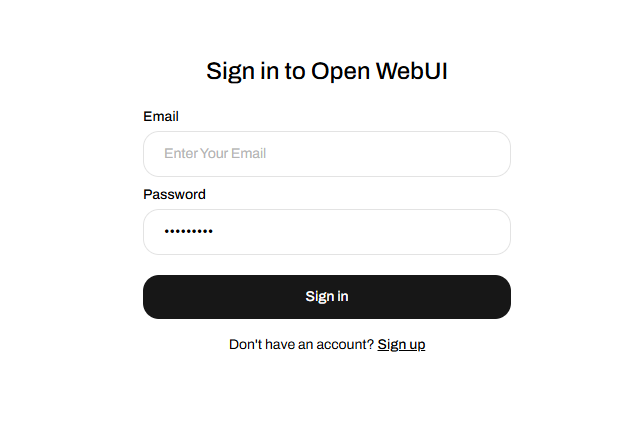

4.3 设置管理员账户

首次登录需要设置一个管理员账户

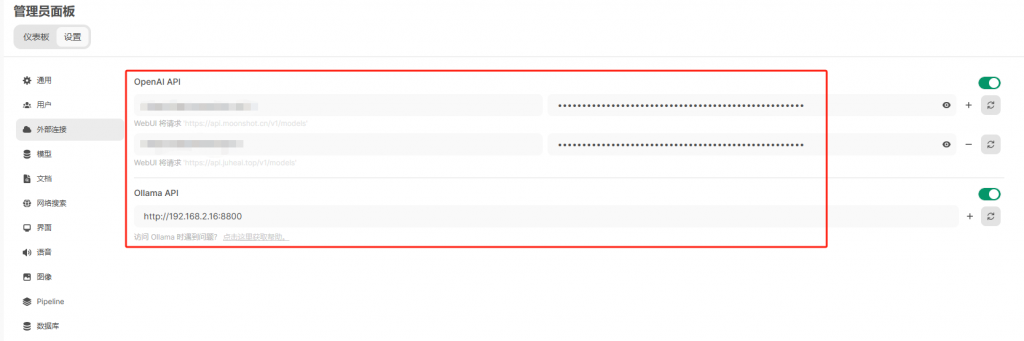

4.4 配置ollama

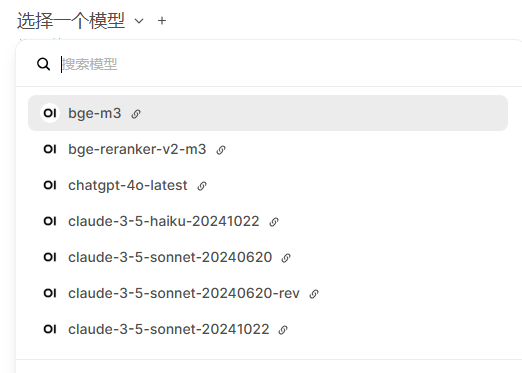

如果是本机安装的ollama,并且没有修改端口号的情况,OpenWebUI默认设置就可以连接到ollama,如果不是上述情况,需要设置一下。

OpenWebUI也可以使用外部在线模型,如ChatGPT、ChatGLM、通义千问、月之暗面等等。

5.安装SearXNG

5.1使用docker安装searxng

教程地址:https://tkmatrix.github.io/searxng/admin/installation-docker.html

主要命令:

$ mkdir my-instance

$ cd my-instance

$ export PORT=8080

$ docker pull searxng/searxng

$ docker run --rm \

-d -p ${PORT}:8080 \

-v "${PWD}/searxng:/etc/searxng" \

-e "BASE_URL=http://localhost:$PORT/" \

-e "INSTANCE_NAME=my-instance" \

searxng/searxng

5.2 修改searxng配置

searxng默认接口返回的格式是html格式,需要增加json格式;

修改支持的搜索引擎,国内无法使用的google、duckduckgo等,需要添加对bing的支持。

修改完配置后需要重启docker容器

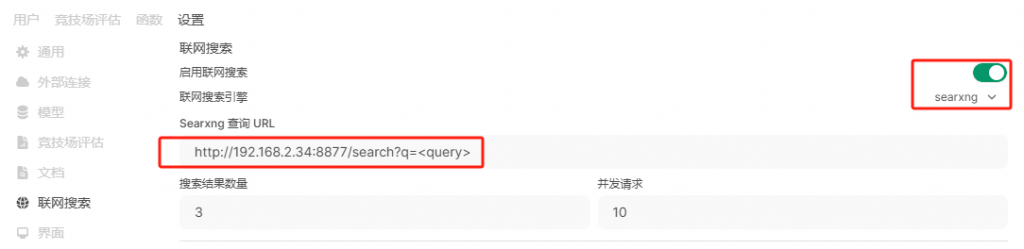

5.3 Openwebui配置searxng

- 在管理员设置界面开启联网搜索功能,并配置好searxng。

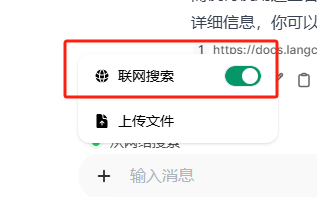

- 在对话之前需要开启联网搜索,默认不开启联网搜索。

- 如果能够搜索到内容,大模型会根据搜索结果进行回答。

- 很多时候searxng返回内容为空,出现回答结果不理想的情况。